Digital Foundry vs. gli architetti di Xbox One

“C'è troppa disinformazione sulle reali capacità della nostra console”.

Due mesi dopo il lancio ufficiale della prossima generazione di console, molti si sono già fatti un'opinione ben precisa della potenza di elaborazione grafica di entrambe le piattaforme ancora prima che un singolo gioco sia stato pubblicato. Questo perché le specifiche tecniche di entrambe le console sono ormai di dominio pubblico, in particolare la potenza del processore grafico e la larghezza di banda passante. Sulla carta non dovrebbe esserci praticamente partita: PlayStation 4 sovrasta l'Xbox One a un livello tale che una discussione ragionata sui meriti tecnici di entrambe le piattaforma sembra improponibile. Eppure usano la stessa tecnologia di base targata AMD su cui Sony ha installato una memoria più veloce e un chip grafico più capace. Ma è veramente tutto così semplice?

Alla luce di dati tecnici e pure supposizioni sul reale vantaggio di PS4 abbiamo deciso di andare più a fondo sulla questione chiedendo direttamente Microsoft quanto ci sia di vero su queste presunte differenze tecniche e lo abbiamo fatto andando alla fonte, grazie a una conference call con due tecnici di Microsoft che hanno fatto parte del team di progettazione della nuova console. Ingegneri appassionati che in questo modo hanno avuto la possibilità di chiarire molti aspetti relativi alle controversie che hanno animato la fase di presentazione in un colloquio approfondito. Non appena la conversazione è cominciata, si è capito subito che l'argomento di base della discussione sarebbe stato molto preciso: perché Xbox One è una console tecnicamente bilanciata in tutti i suoi componenti.

"Per disegnare una buona console, occorre considerare tutti gli aspetti chiave di hardware e software: è la combinazione di questi due elementi che permette di ottenere un buon bilanciamento di prestazioni,” ci ha spiegato l'ingegnere di Microsoft Andrew Goosen.

"Siamo davvero molto lieti di avere l'opportunità di parlare con voi circa la progettazione di Xbox One. C'è un sacco di disinformazione a riguardo visto e ti posso dire immediatamente che siamo davvero molto orgogliosi del nostro design. Pensiamo di avere realizzato una console molto equilibrata capace di ottime prestazioni, in particolare in grado di gestire cose diverse dal mettere in fila tante ALU [singoli core grafici]. Ci sono anche un certo numero di aspetti di progettazione e requisiti di sistema di cui abbiamo tenuto conto come latenza, frame-rate e che i giochi non siano interrotti dal lavoro del sistema operativo e altri elementi che hanno avuto una certa priorità nella stesura delle linee guida del nostro design."

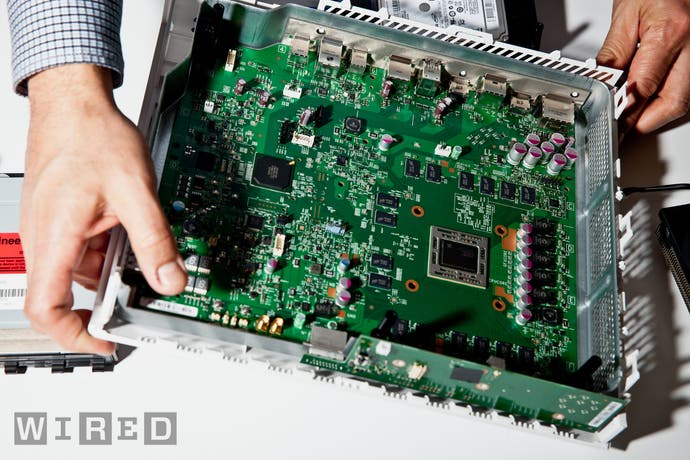

"Andrew ha spiegato il concetto di fondo molto bene: volevamo costruire una console ad alte prestazioni ma anche più efficiente dal punto di vista del consumo energetico," spiega il team manager dell'architettura hardware Nick Baker. "Volevamo rendere la console l'elemento centrale del salotto: dal punto di vista dell'audio/video volevamo realizzare un dispositivo in grado di trasmettere e ricevere contenuti video digitali per renderlo realmente multimediale in grado di fare da punto focale per l'intrattenimento degli utenti."

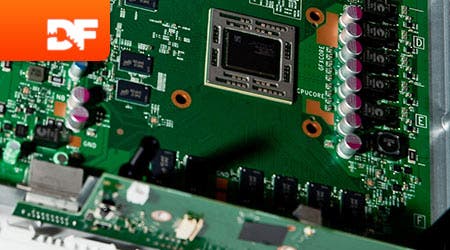

Abbiamo visto che le funzioni multimediali della dashboard di Xbox One sono molto efficienti ma l'attenzione deve per forza essere rivolta ai giochi. Ci sono due grandi polemiche sulla progettazione dell'Xbox One che la fanno ritenere più debole di PlayStation 4: la configurazione della memoria e la quantità di potenza della GPU. Entrambi i sistemi hanno 8GB di RAM, ma Sony ha scelto 8GB di veloce GDDR5 con 176MB/s di banda, mentre Microsoft ha optato per la DDR3 caratterizzate da una larghezza di banda nominale massima di soli 68GB/s. Tuttavia, questa RAM è integrata da un cuscinetto di ESRAM integrato sul chip e negli ultimi test svolti da Microsoft pare che il valore si attesti a 204GB/s. In teoria, mentre la ripartizione delle risorse tra i due pool di memoria sarà un fattore tecnico di grande importanza, la vostra console ha scelto un approccio diverso da quello della concorrenza per garantire un'adeguata larghezza di banda a tutto il sistema.

La gestione della memoria è uno dei punti più controversi che separano i due sistemi. Ci siamo quindi posti due domande: se le GDDR5 sono da tempo la configurazione preferita per la gestione del calcolo tridimensionale, perché Microsoft non ha fatto questa scelta, visto anche il suo potenziale economico? E poi, era giusto presumere che questa maggiore larghezza di banda di RAM fosse stata esclusa molto presto nel processo di progettazione della console, e, se sì, perché?

"Per ottenere la migliore combinazione tra prestazioni, capacità di memoria e consumo energetico la GDDR5 può creare dei problemi", ha spiegato Nick Baker."L'ESRAM invece costa molto poco sotto il profilo del consumo energetico e ha l'opportunità di dare al sistema una larghezza di banda molto elevata. È possibile ridurre la larghezza di banda sulla memoria esterna risparmiando un sacco di corrente e sul costo della materia prima. Nelle scelte progettuali dell'Xbox One la combinazione tra un'alta capacità di memoria, un consumo energetico basso e tanta banda passante era un elemento chiave e per ottenerlo non c'erano molti di modi di farlo se non tramite l'uso della ESRAM."

La controversia sulla banda passante combinata

Baker ha voluto sfatare la convinzione che il team avesse creato un design che non permetteva di accedere alla ESRAM e al pool di memoria DDR3 contemporaneamente. I critici dicono che l'aumento di banda era fasullo ed ottenuto truccando dati che non avevano riscontro in una situazione tecnica reale.

"La cache di ESRAM e il pool di memoria DDR3 caratterizzano un sistema costituito da otto controller di memoria totali, quindi ci sono quattro controller di memoria esterna (che sono a 64-bit) che vanno alla DDR3 e poi ci sono quattro controller di memoria interna a 256-bit collegati alla ESRAM; Questi sono tutti collegati tra loro e quindi si possono scambiare dati direttamente e contemporaneamente tra DRAM e ESRAM."

La polemica sull'efficienza della ESRAM ha colto il team di progettazione di sorpresa. L'idea che sia passata la convinzione che sarà complesso lavorare con l'Xbox One è abbastanza difficile da digerire per la stessa squadra che ha prodotto l'Xbox 360, di gran lunga la console più accessibile allo sviluppo specialmente nei primi anni di vita della generazione attuale.

"Questa polemica è piuttosto sorprendente, soprattutto se si pensa che l'ESRAM è l'evoluzione della eDRAM presente su Xbox 360. Nessuno ha messo in dubbio che su Xbox 360 siamo stati in grado di sfruttare la larghezza di banda dell'eDRAM facendola lavorare in parallelo con la larghezza di banda della memoria di sistema. Esattamente com'erano state dettate le specifiche di sistema.", spiega Andrew Goosen.

"Su Xbox 360 avevamo fondamentalmente affiancato tutti i nostri vertex buffer e tutte le nostre strutture di memoria di sistema agli indirizzi di rendering, colore, profondità, buffer stencil che in precedenza venivano gestiti dalla eDRAM. Con Xbox One abbiamo fatto la stessa cosa: nell'architettura del pool di memoria, l'ESRAM è la stessa estensione naturale della eDRAM su Xbox 360. Si tratta fondamentalmente di una bella evoluzione del design di Xbox 360 che ci ha permesso di aggirare un sacco di limitazioni che avevamo incontrato usando l'eDRAM.

"L'Xbox 360 è stata indubbiamente la piattaforma console più semplice su cui lavorare finora e non è stato così difficile per i nostri sviluppatori adattarsi all'uso delle eDRAM. In molte situazioni ci siamo trovati a chiederci quanto sarebbe stato bello dal punto di vista tecnico se un intero target di rendering potesse essere gestito al di fuori dell'eDRAM . E così abbiamo fatto in modo che su Xbox One fosse possibile eseguire un overflow dei dati dall'ESRAM su DDR3. In questo modo l'ESRAM è completamente integrata nelle nostre tabelle di paging e così è possibile integrare perfettamente ESRAM nella memoria DDR. Dal nostro punto di vista si tratta di un grande miglioramento nella performance piuttosto che di una semplice evoluzione nel design dell'Xbox 360: in tutta onestà, siamo stati molto sorpresi delle polemiche che sono seguite all'annuncio delle nostre specifiche tecniche."

" L'Xbox 360 è stata indubbiamente la piattaforma console più semplice console sui cui lavorare finora e non è stato così difficile per i nostri sviluppatori adattarsi all'uso delle eDRAM "

In effetti, il livello di coerenza tra l'ESRAM e il pool di memoria DDR3 sembrerebbe essere molto più flessibile rispetto a quanto si pensava precedentemente. Molti credono che 32MB di ESRAM sia però pochi per gestire in autonomia interi elementi di rendering: stando a quanto suggerisce Goosen tuttavia, gli sviluppatori possono usare entrambi i pool di memoria per aggirare questo problema.

"Oh, assolutamente si e si può usare anche in modo che porzioni del render abbiano pochissimo overdraw, (il rallentamento del frame rate quando si cercano di renderizzare più oggetti di quelli che il sistema riesce a gestire ND Digital Foundry). Per esempio se ci si trova a sviluppare un gioco di guida e il cielo è causa di rallentamenti si possono salvare i subset di memoria nella RAM DDR e liberare spazio per gestire al meglio 32 MB di ESRAM. A questo si aggiunge anche la possibilità di aggiungere istruzioni personalizzate che permettono di gestire in tempo reale l'allocazione di quei preziosi 32MB di RAM.

Come può il valore di banda passante ESRAM raddoppiare di colpo?

Un certo scetticismo ha riguardato l'improvviso aumento della banda dalla ESRAM dai 102GB/s dichiarati inizialmente agli attuali 204GB/s. Abbiamo dato credito a questa notizia basandoci su un primo documento di sviluppo dello scorso aprile giunto su Internet, ma molti non erano convinti del valore riportato che semplicemente non pareva essere realistico. Come si è arrivati a questo enorme aumento di banda teorica?

Nick Baker ha spiegato l'arcano: "Quando abbiamo iniziato il progetto abbiamo fornito agli sviluppatori una specifica di massima per dar loro un'idea di fondo sui limiti tecnici della console prima ancora di realizzare i prototipi o le simulazioni di specifiche. Eravamo partiti da una banda minima di 102GB/s poi è diventata 109GB/s dopo l'aumento del clock della GPU: il fatto è che si trattava solo di velocità teorica e ci siamo quindi resi conto, solo all'atto pratico, che si poteva arrivare molto più in alto."

E infatti la rivelazione che la ESRAM poteva scrivere e leggere simultaneamente allo stesso momento pareva essere piuttosto improbabile anche in relazione alla documentazione che era filtrate su Internet.

"Il sistema gestisce quattro linee di memoria da 8MB ciascuna ma non si tratta di spezzoni di memoria contigui in quanto ognuno dei quattro pool è a sua volta suddiviso in otto moduli ciascuno da cui si può leggere o scrivere singolarmente" spiega Baker.

"Quindi non è corretto parlare di ESRAM nel suo complesso ma di un architettura che permette un lavoro in parallelo di vari moduli tra loro. Ovviamente se si continua a lavorare sempre nella stessa area di memoria in continuo non si usa tutta la banda a disposizione ma solo 140-150GB/s rispetto al picco massimo teorico di 204 GB/s. Si tratta di un sistema complesso che può essere usato più o meno efficacemente a seconda di come si gestisce l'accesso alle risorse e che permette letture e scritture simultanee da e verso l'ESRAM e da e verso la DDR3 ed uno degli aspetti tecnicamente più complessi che volevamo chiarire."

"Quindi, se lavorando con la ESRAM state solo scrivendo o leggendo dati il sistema non può andare oltre i 109GB/s. In una situazione normale che prevede un alternarsi di cicli di letture e scritture questo valore aumenta per forza visto che questo movimento bidirezionale dei dati è tipico di un pool di memoria in cui i render e i depth buffer vengono aggiornati di continuo e quindi traggono un grosso vantaggio da cicli simultanei di lettura/scrittura."

La banda passante è un conto, ma le capacità grafiche sono effettivamente un altro paio di maniche: la PS4 è chiaramente in vantaggio sotto questo aspetto (18 di PS4 contro le 12 di Xbox One) in termini di numero di unità di calcolo, un dato oltre ogni forma di dubbio che sicuramente compone uno degli elementi di maggiore interesse nella lista delle specifiche di PS4. Anche in questo caso le differenze sono meno marcate di quanto ci si potrebbe aspettare visto che Andrew Goosen stesso conferma che la tecnologia di base delle GPU integrate deriva dalla stessa famiglia di processori targata AMD definita "Island" ancora prima di parlare delle deficienze della console di Microsoft in dettaglio.

"Esattamente come i nostri concorrenti, il nostro chip grafico è basato sulla famiglia di chip denominata Sea Island, ma in realtà abbiamo effettuato alcune modifiche in molti settori dell'architettura del core. La variante più evidente riguarda il numero di unità di calcolo inserite sul die ed è stato un aspetto su cui ci siamo concentrati sin dall'inizio. Come a dire, contiamo il numero di CU e i Gigaflop e dichiariamo il vincitore in base a questo. È più o meno la stessa situazione che si pone al momento di acquistare una scheda video. Si controllano effettivamente solo le specifiche o si guardano anche i benchmark?"

"Innanzitutto, non ci sono ancora giochi in grado di dimostrare la schiacciante superiorità dell'hardware Sony e non essendoci i giochi non è possibile dire quale sarà la reale differenza di prestazioni tra le due piattaforme. I giochi saranno i reali benchmark e sui nostri prototipi abbiamo già avuto la possibilità di far girare parecchia roba e controllare effettivamente quanto fosse bilanciato l'hardware. Il bilanciamento è effettivamente l'elemento chiave nel fornire una buona performance su una console di gioco perché non si vuole che un collo di bottiglia comprometta le prestazioni dell'intero sistema."

Le modifiche alla performance e al bilanciamento di Xbox One

L'approccio di Microsoft è stato quello di andare alla produzione finale della console sapendo che ci sarebbe stato spazio per aumentare le performance del silicio in versione definitiva. Titoli attualmente in produzione sono stati usati per determinare quanto delle risorse di riserva sarebbero state utilizzate.

"Il bilanciamento è la chiave per una performance effettiva: è stato bello lavorare su Xbox One con Nick e il suo team: i ragazzi dedicati al design del sistema hanno creato un ambiente in cui abbiamo avuto la possibilità di effettuare alcuni aggiustamenti dell'ultimo minuto," ha rivelato Goosen. "Si trattava della prova del nove che avrebbe risposto alla domanda cruciale che ci eravamo posti due anni fa in fase di analisi e simulazione della performance cercando di indovinare le richieste hardware dei giochi di oggi: abbiamo preso le giuste decisioni in relazione al bilanciamento delle specifiche hardware? Alzare leggermente la frequenza di clock ha risposto a questa domanda e alla nostra esigenza di avere uno spazio di manovra in questo senso."

"Sapevamo di avere un certo margine ma non sapevamo quando fino a che non c'erano titoli reali su cui farlo girare. Quanto si può spingere GPU e CPU per migliorare la performance?”

"Potrà sembrare banale ma si tratta di un vero e proprio lusso quando si tratta di lanciare una console: normalmente bisogna ridurre le frequenze di calcolo,” afferma Goosen. "Per una volta abbiamo avuto l'opportunità di decidere dove e come migliorare la performance e per farlo è stato molto piacevole avere titoli di lancio che ci permettessero di prendere una decisione consapevole a riguardo."

Goosen ci ha spiegato anche che il chip grafico dell'Xbox One attualmente contiene due unità di calcolo addizionali come avevamo in precedenza sospettato. La presenza di quell'hardware ridondante che invece sulle console in vendita al pubblico è disattivato, ha permesso a Microsoft di effettuare delle interessanti comparazioni sul guadagno di prestazioni effettivo che deriva dalla presenza di un numero superiore di CU o da un overclock di sistema mirato.

"Ogni console in versione developer dispone effettivamente di 14 unità di calcolo integrate sul silicio con scopi di ridondanza in fase di produzione. Noi abbiamo avuto la possibilità di sperimentare quale sarebbe stato l'effettivo beneficio prestazionale di usarne 14 invece di 12 rispetto invece a un normale overclock. I risultati non ci hanno sorpreso: abbiamo fatto girare un sacco di test con molti dei titoli di lancio e abbiamo visto che le console impregnate a far girare le demo non beneficiavano delle due unità di calcolo addizionali attivate quanto invece l'overclock del processore che si attestava a un 6.6% di prestazioni in più."

Se si fanno le proporzioni in relazione alla presunta potenza computazionale di due unità di calcolo extra, il conto parrebbe non tornare ma, come confermato dalla nostra recente analisi, per non parlare dei benchmark paralleli su PC, l'aumento o diminuzione delle CU non scala verso l'alto o verso il basso in modo lineare: occorre tenere conto della legge dei rendimenti decrescenti.

"Tutte le Xbox One in versione dev kit attualmente hanno 14 unità di calcolo sul silicio e ci siamo accorti con i titoli di lancio che con quelle due unità in più attivate il guadagno non era efficace quanto l'upgrade alla velocità del processore."

"Stando ai calcoli effettuati da molti appassionati su Internet, il valore avrebbe dovuto essere molto più alto, di circa il 17%, ma misurando le prestazioni con I giochi, che sono quelli che contano alla fine, dal punto di vista ingegneristico è stato meglio limitarsi ad alzare il clock. Ci sono vari colli di bottiglia in molti punti della pipeline di elaborazione grafica che possono impedire di arrivare alle prestazioni che sulla carta dovrebbero essere tecnicamente possibili se l'architettura generale della console è sbilanciata."

Nick Baker ha effettuato una precisazione a riguardo: "Aumentare la frequenza impatta sulle prestazioni di tutta la GPU mentre aggiungere delle unità di calcolo migliora “solo” le prestazioni di shader e ALU". Goosen gli fa eco: “Esatto. Modificando il clock, non solo si aumenta la performance delle ALU ma anche il vertex e pixel rate e persino la banda della ESRAM per non parlare della diminuzione dei colli di bottiglia che stanno tutto intorno al sistema come le chiamate di rendering che si muovono lungo la pipeline e la performance delle letture sui pool di ram GPR (General Purpose Ram)".

La potenza di calcolo della GPU e l'importanza della CPU

Goosen inoltre ritiene che I documenti di Sony usciti su VGLeaks confermino la tesi di Microsoft: "Sony conferma la nostra tesi: loro dicono che il loro sistema era bilanciato per 14 unità di calcolo: hanno usato un termine preciso: “bilanciato” proprio perché il bilanciamento è cruciale per un design efficiente. Noi tuttavia abbiamo scelto un percorso diverso visto che i test che abbiamo eseguito mostravano spazi di miglioramento sotto il profilo del numero di unità di calcolo perché abbiamo messo in conto più CU di quelle che ci servivano. Per i nostri titoli ci sarà quindi spazio di crescita nel tempo in termini di utilizzo del potenziale di calcolo tridimensionale."

Fondamentalmente, invece di concentrarsi sulla forza bruta computazionale, la filosofia di Microsoft è stata che sia CPU sia GPU necessitano di un accesso a bassa latenza alla stessa memoria. Goosen ha precisato che il sistema di tracciamento scheletrico di Kinect su Xbox 360 è un esempio del perché è stata scelta questa strada.

Il team ha voluto anche spiegare in dettaglio perché l'aumento prestazionale di 150MHz della CPU sia più importante di quanto molti non credano. Goosen ha precisato che l'origine della maggior parte dei rallentamenti deriva dalla CPU piuttosto che la GPU. “L'aggiunta di cicli di clock ci ha permesso di aggiungere un certo margine di prestazioni a molti giochi che abbiamo scoperto essere legati più alla potenza del processore centrale che non a quello del processore grafico: quello che sembra essere un piccolo bonus, per noi si tratta di un guadagno significativo nel fare in modo che il frame rate sulla nostra console sia il più stabile possibile."

Questo in parte spiega la presenza di numerose componenti hardware personalizzate presenti all'interno della console: i Data Move Engine sono pensati proprio per liberare risorse della CPU e tenerla sempre pronta all'uso. I test iniziali hanno mostrato che i colli di bottiglia potevano essere un grosso problema che è stato risolto aumentando la frequenza di clock e aggiungendo soluzioni personalizzate denominate “silicio a funzione fissa”, ovvero una serie di chip integrati nel processore centrale della console.

"Abbiamo un sacco di elementi dedicati allo scarico di compiti specifici della CPU mentre si gioca come il processore di comando SHAPE e questo ci ha dato spazio di manovra nella gestione della velocità di clock superiore. Gli elementi che aiutano la CPU a svolgere il suo lavoro sono molti, ma pare che i Data Move Engine siano quelli più efficienti nello scaricarlo di oneri computazionali particolarmente gravosi.

"Anche il funzionamento dei Data Move Engine merita di essere spiegato: immaginate di aver renderizzato l'informazione di un depth buffer immagazzinandola nella ESRAM e poi passate ad un secondo depth buffer. Ora immaginate di aver bisogno di caricare le informazioni relative a una texture nella memoria DDR per un uso a breve termine. I Data Move Engine permettono di muovere tutte queste informazioni tra i pool di memoria per liberare la GPU da questo compito dedicando quel tempo risparmiato all'elaborazione di un altro render piuttosto che allo spostamento di dati avanti e indietro attraverso la memoria."

"Questo è solo un esempio del genere di attività che abbiamo svolto nella progettazione della GPU e degli hardware overlay per assicurare frame-rate più consistenti possibile," ha aggiunto Goosen. "Abbiamo due layer: uno è riservato alla gestione del 3D mentre l'altro è pensata per elementi bidimensionali come possono essere l'hud. Anche lo scaler è di alta qualità rispetto a quello dell'Xbox 360 e ci permette di cambiare i parametri della risoluzione dinamica praticamente frame per frame."

La risoluzione dinamica non è una soluzione nuova, l'abbiamo vista implementata in un sacco di titoli dell'attuale generazione di console. Il primo esempio è stato Wipeout HD: l'impatto sulla qualità dell'immagine può essere pesante fino a 720p, ma ad alte risoluzioni e in concerto con un algoritmo di scaling efficiente, può essere una valida alternativa nell'equalizzare la performance delle versioni crossplatform di molti giochi.

"Ho parlato dei problemi della CPU che causano colli di bottiglia al frame rate. I carichi di lavoro della GPU sono in genere più coerenti nelle successioni di frame dovuti al fatto che non incontrano grossi picchi nelle prestazioni e quindi lo scaler dinamico può lavorare basandosi su quello.” ha spiegato Goosen.

"Sempre con i nostri titoli di riferimento abbiamo visto che l'adozione della risoluzione dinamica è molto efficace nell'evitare frame rate incostanti. Quando il gioco entra in'un area dove il limite si avvicina è possibile diminuire la risoluzione al volo mantenendo quella dell'HUD inalterata mentre la schermata 3D diminuisce in tempo reale. Come giocatore preferisco un frame rate solido e un piccolo compromesso nella qualità dell'immagine piuttosto che uno stuttering molto evidente."

"Da un punto di vista di rapporto potenza/risparmio energetico, gli elementi hardware dedicati a compiti specifici permettono di risparmiare parecchia corrente,” spiega Nick Baker. "La compressione dati è un buon esempio o anche la decodifica dei filmati che permette di alleggerire il carico di lavoro quando il Kinect è attivo. In realtà, quando si parla di soluzioni dedicate all'interno di Xbox One, c'è molto di più dei Data Move Engine che spostano blocchi di memoria da una parte all'altra del sistema."

Abbiamo avuto modo di parlarne con gli ingegneri di Microsoft per oltre un'ora e mezza. Come avete intuito, il resoconto appena letto è una sintesi dei punti più interessanti e comprensibili a un pubblico comunque tecnicamente molto smaliziato. Siamo andati talmente in dettaglio al punto da aver trascurato la data di lancio della console del prossimo Novembre. Abbiamo quindi chiesto ai nostri interlocutori come ci si sente a vedere uscire una console dai nastri della produzione dopo aver trascorso anni a concepirla e svilupparla.

"Certo, dare vita a un oggetto così complesso come questo è una grande soddisfazione, ma il mio team è sempre al lavoro su altri progetti paralleli quindi non saremo completamente fermi a goderci le celebrazioni," afferma Baker.

Tocca tuttavia a Goosen chiudere quest'intervista:

"Per me il premio più grande è di giocare ai titoli e renderci conto che sono effettivamente belli e tecnicamente solidi anche grazie al nostro duro lavoro. Come grafico, posso garantirti che vedere i pixel in movimento sullo schermo è fonte di grande soddisfazione."

Traduzione a cura di Matteo “Elvin” Lorenzetti.