G-Sync: la fine dello screen-tear - articolo

Il Digital Foundry sulla tecnologia di Nvidia per PC.

Nvidia ha svelato una nuova tecnologia in grado di eliminare definitivamente lo screen tear dai giochi per PC. Denominata "G-Sync", è una combinazione tra la gestione della frequenza di aggiornamento del monitor che lavora di concerto con un software disponibile esclusivamente solo per la linea di schede grafiche della famiglia Kepler. Si tratta di un risultato fenomenale che ha guadagnato agli ingegneri di Nvidia elogi da tre dei nomi tra i più celebri dell'industria del videogioco: John Carmack di id Software, Tim Sweeney di Epic e Johan Andersson di DICE. Questi tre guru della grafica 3D erano tutti sul palco alla presentazione di Nvidia a tessere le lodi di questa nuova soluzione tecnica come raramente ci era capitato di vedere in passato.

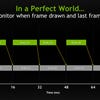

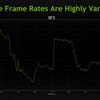

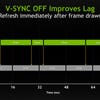

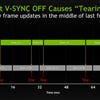

Un problema fondamentale dei videogiochi moderni è che i monitor funzionano a una velocità di clock distinta da quella della console o del PC. Su un tipico schermo a 60Hz l'immagine viene aggiornata ogni 16.66 millisecondi. Se la console o il PC hanno già pronto nel framebuffer l'immagine (detta anche frame) successiva è possibile mantenere la sincronizzazione con lo schermo ma questo significa che il frame deve essere generato per intero entro i 16,67 millisecondi successivi altrimenti occorrerà attendere un altro ciclo da 16,67 millisecondi. Questo è il problema fondamentale relativo alla performance dei giochi che funzionano con la sincronia verticale attiva (V-sync): se questo intervallo di tempo non viene rispettato e il frame viene comunque visualizzato a schermo, appare il caratteristico disallineamento dell'immagine che colloquialmente definiamo “screen tear”.

Varie soluzioni sono state studiate nel corso degli anni: su console, la tendenza generale è sempre stata quella di quella di bloccare a 30 o (molto raramente) 60 FPS il frame buffer disattivando la sincronia verticale quando il frame rate scendeva sotto questa soglia, cedendo quindi all'introduzione dello screen tear solo quando era assolutamente necessario. Altre tecnologie interessanti includono l'upscale del frame rate imitano l'effetto di ammorbidimento della sequenza d'immagini visto in azione su alcuni televisori ad alta definizione, ma non sono mai state implementate finora in un videogioco commerciale.

La tecnologia di G-Sync di Nvidia punta a risolvere il problema a livello hardware, consentendo al processore grafico di prendere il controllo del monitor: invece di rimanere bloccato a un aggiornamento di 16,67 millisecondi, lo schermo viene aggiornato alla velocità richiesta dalla GPU per farla aderire a quella del frame buffer. Il risultato è l'assenza di fotogrammi duplicati sullo schermo e quindi la sparizione dello screen tear: ovviamente la massima velocità di aggiornamento condiziona questa soluzione che abbiamo visto girare al massimo su un monitor Asus a 144Hz.

"Gli schermi ci hanno costretto finora ad accettare il compromesso della sincronia verticale. Il G-Sync è il primo tentativo di risolvere il problema."

Ora il grosso punto interrogativo è: se la scheda grafica è in grado di aggiornare l'immagine sul monitor a piacimento, questo si nota nell'azione a schermo e fino a che punto? Nvidia ha preparato due demo per illustrare come funziona il G-Sync permettendoci di porre anche qualche domanda su come funziona questa tecnologia in azione. Al fine di illustrare questa tecnologia nel modo più efficace, due sistemi erano stati preparati uno di fianco all'altro: uno con un monitor tradizionale e uno con il G-Sync abilitato. Entrambi erano collegati a una scheda video dotata di GPU Kepler, la GTX 760.

La prima demo comprendeva una sorta di gazebo con un pendolo oscillante nel mezzo. Zoomare sul pendolo metteva in evidenza del testo: in questo modo la demo girava tranquillamente a 60 FPS su entrambi i sistemi e il risultato era decisamente ottimale. Dopodiché il frame rate è stato abbassato artificialmente sul sistema normale prima a 50 e poi a 40 FPS. Il risultato era quello previsto: uno scattio evidente causato dalla ripetizione di alcuni frame inviati al monitor che girava a 60 Hz. Poi gli stessi rallentamenti sono stati introdotti sul sistema su cui girava il G-Sync ma stavolta non si notavano differenze evidenti nella riproduzione. La demo è rimasta super-fluida.

Dopo questo test, il V-sync è stato disabilitato sul sistema tradizionale causando l'apparizione del disallineamento dell'immagine a 50 FPS che cominciava a muoversi in su e in giù man mano che il frame oscillava tra i 40 e i 50, una situazione praticamente inaccettabile anche solo per superare un semplice test qualitative. A peggiorare le cose si metteva lo script d'inquadratura della scena che prevedeva continue panoramiche avanti e indietro del gazebo con tanto di rotazioni: una situazione tipica per favorire lo screen tear che abbiamo subito notato. Sul monitor a fianco non accadeva invece nulla di tutto questo: il G-Sync registrava la riduzione nel frame rate ma non si notava alcun impatto sulla fluidità. L'esperimento è stato ripetuto con la demo di Tomb Raider, con risultati identici: disallineamenti e scattosità sul sistema normale, una fluidità perfetta come il velluto sul gemello in cui la scheda video gestiva anche il refresh del monitor.

"Abbiamo notato qualche lieve fenomeno di ghosting sulla macchina dotata di G-Sync quando si girava molto sotto i 60 FPS"

Quindi il G-Sync è una bacchetta magica che elimina screen tear e scattosità senza effetti collaterali di sorta? La risposta è negativa. Il testo sul pendolo nella demo con il gazebo testimonia che uno scambio è inevitabile e questa moneta si chiama ghosting. L'immagine è infatti cristallina a 60 FPS su entrambi i sistemi, ma man mano che si scende con il frame rate, questo diventa più evidente. Siamo alla ricerca di un effetto simile nella demo di Tomb Raider ma non siamo riusciti ad individuarlo, probabilmente perché il frame rate non è mai sceso sotto i 48 FPS.

A parte questo, la realtà è che Nvidia ha finalmente raggiunto una soluzione tecnica in grado di consegnare lo screen-tear e lo scattosità indotta dalla sincronia verticale al passato. Abbiamo approcciato questa nuova tecnologia con tutto lo scetticismo del mondo, ma dopo averla vista in azione, possiamo affermare tranquillamente che funziona. Occorre scendere ad alcuni compromessi come il ghosting ma si tratta di uno scambio su cui nessuno si fermerebbe a riflettere nemmeno per un secondo. Per quanto si noti, il ghosting non compromette l'esperienza di gioco tanto quanto gli effetti collaterali di un setup tradizionale le cui differenze con la nuova soluzione di Nvidia sono semplicemente abissali.

Solo buone notizie? Non proprio visto che per ottenere questi risultati bisogna soddisfare due requisiti: montare una scheda video Nvidia di classe Kepler in concomitanza con un monitor in grado di supportare questa tecnologia. In teoria, i monitor attuali capaci di arrivare a 144Hz potrebbero essere ricondizionati con una board in grado di garantire funzionalità G-Sync e l'Asus VG248QE è già stato confermato come il primo dotato di questa feature. La domanda è fino a che punto i produttori vorranno offrire uno scaler in grado di supportare la nuova soluzione di Nvidia piuttosto che mettere sul mercato una nuova generazione di monitor adatti allo scopo?

"La buona notizia è che il G-Sync è una tecnologia stupefacente. La cattiva è che molti dovranno cambiare scheda video e monitor"

Oltre a questi due interrogativi piuttosto legittimi, la terza domanda che ci siamo posti riguarda la tipologia di risoluzioni supportate: già, perchè se i monitor da 1080p saranno sicuramente supportati, rimane da vedere se verranno invitati alla festa anche quelli da 2560x1440 o da 4K che abbiamo avuto modo di provare recentemente. È proprio in questo settore che una soluzione di questo genere potrebbe rappresentare una rivoluzione non da poco: far girare alle altissime risoluzioni giochi molto esigenti con la sincronia verticale attivata è una sfida proibitiva per molte schede video di fascia altissima moderne. Pensate a quali vantaggi potrebbe portare un'applicazione diffusa del G-Sync con monitor di livello superiore rispetto a quelli da 1080p che abbiamo visto in azione alla presentazione di Nvidia.

Le premesse non si fermano qui: un sacco di applicazioni potenziali per il G-Sync fanno venire l'acquolina in bocca per come vanno oltre il semplice gaming su PC Desktop. Storicamente le GPU dei laptop da sempre si trovano con il fiato corto nel riprodurre le performance delle normali piattaforme desktop: in questo senso, un monitor per laptop e una GPU già pronti a supportare questa soluzione dovrebbero aiutare a colmare in modo sensibile questo genere di gap prestazionale. La stessa questione vale per il mercato mobile: dopo la presentazione principale, John Carmack parlava delle sfide di ottimizzazione delle piattaforme Android; è impossibile ottenere codice pensato per girare a 56 FPS riuscire a toccare i 60 a causa delle limitazioni dovute al ridotto consumo energetico dei dispositivi mobile. Il G-Sync dovrebbe risolvere problemi come questo.

Insomma, l'arrivo di questa tecnologia sta per cambiare le carte in tavola per quanto riguarda il PC gaming sotto molti aspetti e la presentazione ha messo in una certa agitazione tutta la platea di tester e giocatori PC entusiasti presenti. Questo perché si tratta di professionisti abituati a valutare in un certo modo la performance di determinate schede video; nella nostra recente recensione della Radeon HD 7990 abbiamo puntualizzato che la pratica di registrare semplicemente la pura potenza delle GPU rischia di essere inutile. Bisogna spostarsi maggiormente sulla valutazione della solidità della performance: come potete vedere nell'immagine sottostante, stiamo già preparando i nostri tool di valutazione per includere un elemento di percezione visiva della scattosità. L'arrivo di soluzioni come quella di Nvidia significano che mentre le performance non cambieranno, l'indicatore di consistenza del gameplay percepito diventerà molto importante nella valutazione di una scheda video. I cali di performance non saranno quindi più indicativi della qualità di quello che accade a schermo, ma dell'eventuale ritardo percepito dalla periferica di controllo tra le nostre mani.

"Il G-Sync parifica la velocità di aggiornamento dello schermo a quella del framebuffer rimuovendo completamente frame duplicati o incompleti"

Il problema per chi analizza le prestazioni delle schede video è che le comparazioni tradizionali tra schede video AMD e Nvidia potrebbero perdere senso. Anche se una GPU AMD superasse una concorrente di Nvidia del 10% o 15% ma non presentasse una soluzione simile al G-Sync, sarebbe classificata come la scheda migliore usando i metri di giudizio tradizionali. Allo stesso modo per Nvidia sarebbe difficile differenziare efficacemente la sua gamma di prodotti nella percezione con il pubblico. Differenze di prestazioni massime percepite tra 45 e 52 FPS per esempio verrebbero appiattite dal G-Sync rendendo in un certo senso inutili schede video di fascia e prezzo superiori. Ecco perché le differenze nella qualità del gameplay saranno l'elemento in grado di dire, in futuro, quale sarà la scheda video migliore nel limitare in più possible la latenza nell'input.

Tre settimane fa, avevamo descritto la nuova API di AMD, Mantle, come un'innovazione potenzialmente sismica nel mondo dello sviluppo per PC offrendo un'interfaccia di tipo console all'implementazione dei videogiochi nel mercato PC aumentandone nel contempo le prestazioni. Tuttavia, nel volgere di pochi giorni la concorrenza ha ideato una soluzione tecnica che senza dubbio diventerà il nuovo standard per PC con una differenza sostanziale rispetto ad AMD; la sua implementazione non richiederà alcuna formazione da parte degli sviluppatori. Abbiamo chiesto direttamente a Tim Sweeney e John Carmack quale tra Mantle e G-Sync sia la soluzione più innovativa: entrambi, immediatamente ed inequivocabilmente, hanno risposti Nvidia.

Speriamo quindi di fornirvi una serie di test più completi al più presto possibile: tutto quello che abbiamo visto finora suggerirebbe una nuova rivoluzione alle porte, confortata dall'entusiastico avvallo di tre mostri sacri della grafica applicata al gioco del calibro di Johan Andersson, Tim Sweeney e John Carmack. Prima di decretarne il successo, bisognerà però rispondere a parecchie domande sia relative alla tecnologia in sé sia all'industria in senso lato. In particolare: c'è un limite sotto il quale l'illusione di fluidità del G-Sync viene meno? Dopo l'evento si parlava in modo non ufficiale della soglia dei 35 FPS come limite minimo per non percepire un certo ritardo di risposta dal controller. Allo stesso modo, quale sarà la differenza di prestazioni percepita tra una GTX 760 e una GTX 770 con un gioco in cui sono stati impostati gli stessi livelli qualitativi? E soprattutto, AMD reagirà con una tecnologia simile portando a una frammentazione del mercato PC o Nvidia farà valere il brevetto tagliando fuori la concorrente da questo genere di soluzione tecnica?

"Il G-Sync celebra un matrimonio d'interesse tra processori grafici e tecnologia dei video a un livello che non abbiamo mai visto prima."

Siamo anche curiosi di capire se le console della prossima generazione potranno essere invitate alla festa a un certo punto della loro vita commerciale. Sospettiamo che una soluzione del genere non sia possibile a breve termine in quanto, almeno per il momento, nei salotti nessuno schermo supporta una soluzione del genere e anche Nvidia, da un punto di vista prettamente commerciale, potrebbe essere poco interessata ed esportare il suo know-how. Nel medio e lungo termine la situazione è poco definita: Sony potrebbe introdurre una tecnologia simile, magari permettendo a PS4 di dialogare con gli schermi della linea Bravia, ma difficilmente una soluzione del genere si potrebbe proporre a un pubblico di nicchia. Per fare la differenza la sua diffusione dovrebbe essere capillare.

Il media briefing di Nvidia è stato quindi decisamente interessante: l'arrivo delle prossime Xbox e PlayStation cambierà il mercato console ma anche quello home computer. È netta la sensazione che i produttori di schede video stiano cercando di differenziare il PC dalle console (che ne hanno copiato l'architettura) proponendo nuove soluzioni a vecchi problemi. L'aumento progressivo della potenza delle schede video su base annuale ovviamente aiuta, ma, almeno per il momento, la situazione sembra essere ferma allo standard 1080p. L'evoluzione a breve termine sarà possibile solo esplorando le potenzialità solo della risoluzione 2.5k di cui alcuni modelli sono già sul mercato. Per il momento, lo standard 4K è in una fase sperimentale a causa dei prezzi astronomici degli schermi e della necessità di mettere in SLI o Crossfire più schede video di fascia altissima per supportarli alle risoluzioni che li competono.

Per il momento la risposta di AMD alla sfida di Nvidia è stata quella di prendere per mano le console e portare le ottimizzazioni derivanti dall'hardware appena sviluppato su PC in concomitanza con soluzioni audio di classe superiore. Il confronto è aperto ma, almeno per il momento, la proposta degli ingegneri di Santa Clara appare più intrigante per come cambia le carte in tavola e per l'impatto che può avere sull'esperienza di gioco nel breve termine senza che gli sviluppatori debbano muovere un dito per implementarla. La scattosità e i disallineamenti che tanto ci hanno tormentato in passato sembrano finalmente avere i giorni contati.

Traduzione a cura di Matteo “Elvin” Lorenzetti